Beiträge

YOU COULD’VE INVENTED TRANSFORMERS

/

0 Kommentare

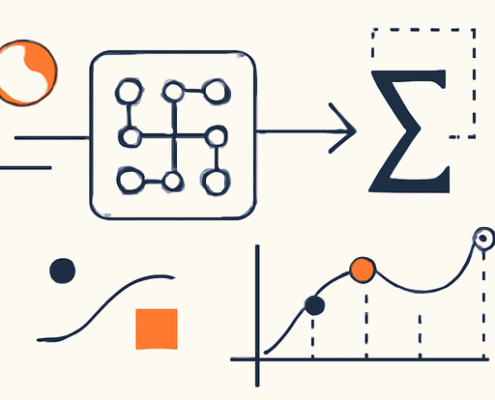

Die grundlegende Architektur von LLMs kann als eine Reihe von einfachen Schritten erklärt werden, die vom 0-Zählproblem der n-grams über Embeddings, neuronale Sprachmodelle bis hin zur Selbstaufmerksamkeit reichen.

Wie Ein-Schicht-Transformer Regelsprachen erkennen: Eine theoretische Analyse der Trainingsdynamik und impliziten Bias

In diesem Artikel werfen wir einen detaillierten Blick auf die Funktionsweise von Ein-Schicht-Transformern und deren Fähigkeit, Regelsprachen zu erkennen, basierend auf einer theoretischen und empirischen Analyse.