Beiträge

Haben LLMs einen guten Musikgeschmack?

/

0 Kommentare

Der Artikel untersucht, ob LLMs wie Claude einen guten Musikgeschmack haben, und beleuchtet die Vorlieben dieser Modelle sowie mögliche Verzerrungen im Reinforcement Learning.

Cohere erreicht eine Bewertung von 6,8 Milliarden Dollar, während Investoren wie AMD, NVIDIA und Salesforce verstärkt investieren

Cohere hat kürzlich 500 Millionen Dollar bei einer Bewertung von 6,8 Milliarden Dollar gesammelt. Der Artikel beleuchtet die Rolle von Cohere im KI-Markt, die Bedeutung von sicheren LLMs und strategische Partnerschaften.

AI-Traffic steigt um 527%: SEO wird neu geschrieben

Der Anstieg des AI-verursachten Webtraffics hat in den letzten Monaten eine bemerkenswerte Dynamik erreicht. Laut dem 2025 Previsible AI Traffic Report ist der Traffic, der von KI-Plattformen wie ChatGPT, Perplexity, Claude und anderen generiert wird, um erstaunliche 527% gestiegen.

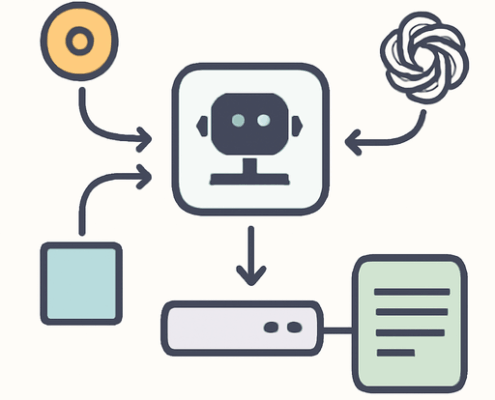

Nexus – Der Open-Source AI Router für eine optimierte KI-Interaktion

Nexus ist ein leistungsstarker Open-Source AI Router, der entwickelt wurde, um die Interaktion von KI-Agenten mit verschiedenen MCP-Tools und großen Sprachmodellen zu optimieren.

LLMs als Teile von Systemen

Die Integration von Large Language Models in komplexe Systeme eröffnet neue Möglichkeiten für die Softwareentwicklung. In diesem Artikel wird die Bedeutung dieser Technologie als Teil eines größeren Systems hervorgehoben.

Von GPT-2 zu gpt-oss: Analyse der architektonischen Fortschritte

In diesem Artikel wird die Entwicklung von GPT-2 zu gpt-oss analysiert, wobei die architektonischen Fortschritte und technischen Optimierungen der neuen Modelle von OpenAI untersucht werden. Der Vergleich mit dem Qwen3-Modell und die Bedeutung der offenen Lizenzierung werden ebenfalls behandelt.

Octo: Der freundliche Open-Source-Coding-Helfer

Octo ist ein freundlicher Open-Source-Coding-Helfer, der Entwicklern hilft, ihre Programmieraufgaben effizienter zu bewältigen. Mit Funktionen wie Multi-LLM-Kompatibilität und Benutzerfreundlichkeit ist es ein unverzichtbares Werkzeug für Programmierer.

Verbesserung der LLM-Kalibrierung mit Label Smoothing

In diesem Artikel untersuchen wir die Herausforderungen der Kalibrierung von großen Sprachmodellen (LLMs) und wie die Technik des Label Smoothing zur Verbesserung der Zuverlässigkeit ihrer Ausgaben beitragen kann.

Die Sicherheitslösung, die MCP immer gebraucht hat

Der mcp-context-protector ist ein neuartiges Sicherheitswerkzeug, das speziell für LLM-Anwendungen entwickelt wurde. In diesem Artikel werden wir die Funktionen und Vorteile des mcp-context-protector sowie die Herausforderungen bei seiner Implementierung untersuchen.