Beiträge

ChatGPT-Container können jetzt Bash ausführen, Pakete installieren und Dateien herunterladen

/

0 Kommentare

ChatGPT hat seinen Code Interpreter aktualisiert, um Bash-Befehle auszuführen, Pakete zu installieren und Dateien herunterzuladen. Dieser Artikel untersucht die neuen Funktionen und deren Anwendungen sowie Sicherheitsaspekte.

Effiziente Schlussfolgerungen durch Sequenz-Destillation

Die Distribution-Aligned Sequence Distillation (DASD) ist eine hochmoderne Destillationspipeline, die innovative Techniken kombiniert, um die Leistungsfähigkeit von KI-Modellen in der Problemlösung erheblich zu steigern.

Vercel vereinfacht seinen Text-zu-SQL-Agenten drastisch

Vercel hat seinen internen Text-zu-SQL-Agenten drastisch vereinfacht, indem 80% der Tools entfernt wurden. Der neue Ansatz nutzt Unix-Befehle und hat die Effizienz und Zuverlässigkeit erheblich gesteigert.

Einführung in die API Parallel Extract von Parallel.ai

Die API Parallel Extract von Parallel.ai ermöglicht es Entwicklern, Inhalte von Webseiten effizient abzurufen und in einem strukturierten Format zurückzugeben. Erfahren Sie mehr über ihre Funktionen und Anwendungsbeispiele.

DeepSeek-OCR: Eine neue Ära der optischen Kompression

Der Artikel behandelt das Open-Source-Projekt DeepSeek-OCR, das die Kompression langer Kontexte durch optische 2D-Abbildung untersucht. Es werden technische Details zur Installation und Nutzung des Modells sowie verschiedene Anwendungsfälle vorgestellt.

8-Bit Rotational Quantization für die Vektorsuche

Die 8-Bit Rotational Quantization ist eine innovative Methode zur Vektorquantisierung, die Speicherbedarf reduziert und die Geschwindigkeit von Vektorsuchen verbessert. In diesem Artikel werden die Funktionsweise, Vorteile und experimentellen Ergebnisse dieser Technik beleuchtet.

LLM-Funktionsaufrufe skalieren nicht; Code-Orchestrierung ist einfacher und effektiver

In diesem Artikel untersuchen wir die Herausforderungen und Lösungen im Umgang mit großen Sprachmodellen (LLMs) und der Code-Orchestrierung, um die Effizienz der Datenverarbeitung zu steigern.

VISUAL AUTOREGRESSION WITHOUT QUANTIZATION (GITHUB REPO)

Die kontinuierliche visuelle autoregressive Generierung ist ein spannendes Forschungsfeld, das in den letzten Jahren an Bedeutung gewonnen hat. Mit der Einführung von EAR wird ein neuer Ansatz vorgestellt, der die Quantisierung vermeidet und stattdessen auf streng korrekte Bewertungsregeln setzt.

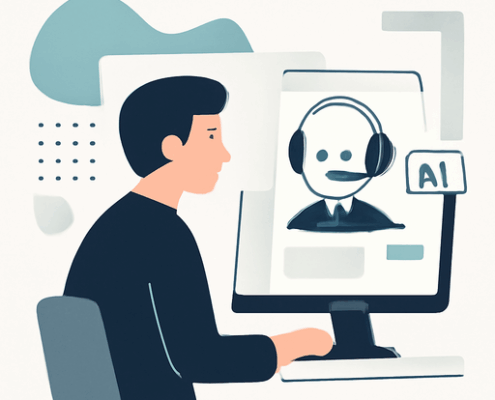

Manus erweitert den kostenlosen Zugang zu seinem virtuellen Desktop-AI-Agenten

Manus hat seine Warteliste abgeschafft und bietet nun allen Nutzern kostenlosen Zugang zu seinem virtuellen Desktop-AI-Agenten, einschließlich täglicher Aufgaben und Bonus-Credits.