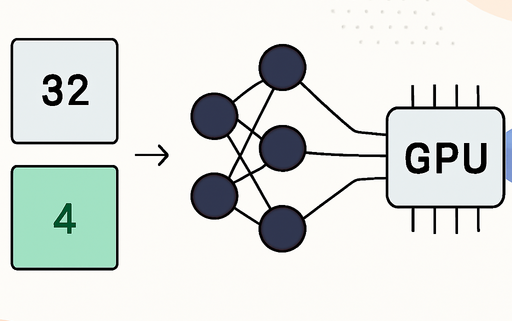

INT4 Quantization-Aware Training: Effiziente Rollouts für große Modelle

Die Entwicklung von KI-Modellen hat in den letzten Jahren exponentiell zugenommen, insbesondere im Bereich der Sprachmodelle. Eine der größten Herausforderungen besteht darin, diese Modelle effizient zu trainieren und auszuführen, ohne dass die Hardwareanforderungen übermäßig steigen. In diesem Kontext hat das INT4 Quantization-Aware Training (QAT) an Bedeutung gewonnen. Es ermöglicht die Implementierung von Modellen mit einer Größe von etwa 1TB auf einer einzigen H200 GPU, was die Effizienz und Geschwindigkeit der Rollouts erheblich verbessert.

Technische Übersicht

Das INT4 QAT kombiniert Techniken der quantisierten Modellierung mit einem geschlossenen Trainingszyklus, der sowohl das Training als auch die Inferenz umfasst. Durch die Verwendung von fake quantization während des Trainings und realer Quantisierung bei der Inferenz wird eine hohe Stabilität und Konsistenz erreicht. Dies ermöglicht es, die Modelle so zu trainieren, dass sie auch bei niedrigerer Präzision eine hohe Leistung erbringen.

Implementierung des INT4 QAT

Die Implementierung des INT4 QAT erfolgt in mehreren Schritten:

- Fake Quantization: Während des Trainings werden die Gewichte in BF16 gehalten, aber es wird Quantisierungsrauschen eingeführt, um das Modell an die INT4-Präzision anzupassen.

- Gradientenfluss: Durch die Verwendung des Straight-Through Estimator (STE) wird sichergestellt, dass die Gradienten während des Rückpropagierens durch die Quantisierungsschicht fließen können.

- Wichtetransformation: Nach dem Training werden die konvergierten Gewichte in das INT4-Format umgewandelt, das für die Inferenz geeignet ist.

- Effiziente Inferenz: Bei der Inferenz werden die INT4-Gewichte verwendet, um die Berechnungen mit W4A16 durchzuführen, was den Speicherbedarf erheblich reduziert.

Vorteile und Herausforderungen

Die Vorteile des INT4 QAT sind zahlreich:

- Speichereffizienz: Durch die Verwendung von INT4 können große Modelle auf einer einzigen GPU untergebracht werden, was die Notwendigkeit für teure Cross-Node-Kommunikation eliminiert.

- Konsistenz: Das Training und die Inferenz sind so gestaltet, dass sie eine hohe Konsistenz aufweisen, was zu einer stabilen Leistung führt.

- Leistungssteigerung: Die Rollout-Effizienz wird durch die Reduzierung des VRAM- und Bandbreitenbedarfs signifikant erhöht.

Dennoch gibt es Herausforderungen, die es zu bewältigen gilt:

- Komplexität der Implementierung: Die Integration von QAT in bestehende Trainingspipelines kann komplex sein.

- Hardwareabhängigkeit: Die Leistung kann von der verwendeten Hardware abhängen, insbesondere wenn native INT4-Tensor-Kerne fehlen.

Ergebnisse

Die Ergebnisse des INT4 QAT zeigen, dass die Modelle in der Lage sind, eine Leistung zu erbringen, die mit der von vollpräzisen Modellen vergleichbar ist. Die Rollout-Geschwindigkeit hat sich erheblich verbessert, und die Trainingszeiten konnten durch die Reduzierung des Speicherbedarfs verkürzt werden.

Ausblick

Die Zukunft des INT4 QAT sieht vielversprechend aus. Mit der Weiterentwicklung der Hardware und der Optimierung der Algorithmen wird erwartet, dass die Effizienz und Leistung weiter gesteigert werden können. Zukünftige Arbeiten könnten sich auf die Verbesserung der Trainingsgeschwindigkeit und die Erkundung neuer Quantisierungsformate konzentrieren, um die Möglichkeiten der KI weiter auszuschöpfen.

Quellenliste:

- Quelle: Squeezing 1TB Model Rollout into a Single H200: INT4 QAT RL End-to-End Practice

- INT4 QAT End-to-End Training

- Unified Multi-Turn VLM/LLM Training

Hinterlasse einen Kommentar

An der Diskussion beteiligen?Hinterlasse uns deinen Kommentar!