Schnelles Modell-Laden mit Tensor R-Fork

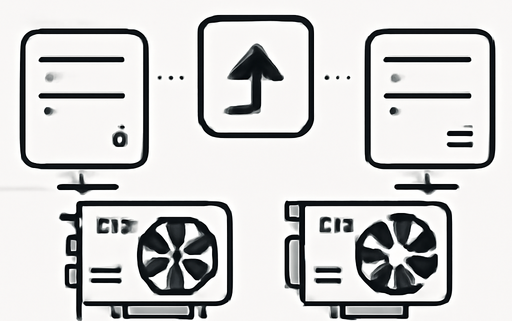

Tensor R-Fork ist eine neuartige Methode zur schnellen Übertragung von Modellgewichten zwischen laufenden Instanzen, die GPU-zu-GPU-Datenübertragung nutzt. Diese Methode reduziert die Ladezeiten erheblich, verringert den Speicherbedarf und sorgt dafür, dass Inferenzdienste ununterbrochen weiterlaufen können.

Einführung

In der heutigen Zeit, in der große Sprachmodelle (LLMs) immer häufiger in produktiven Umgebungen eingesetzt werden, ist die Effizienz bei der Bereitstellung dieser Modelle von entscheidender Bedeutung. Die kalte Startzeit von SGLang-Instanzen, insbesondere die Zeit, die benötigt wird, um Modellgewichte zu laden, stellt oft einen kritischen Engpass dar. Tensor R-Fork bietet eine Lösung, die nicht nur die Ladezeiten drastisch verkürzt, sondern auch die Notwendigkeit reduziert, redundante Modellgewichte auf lokalen Festplatten oder im DRAM zu speichern.

Hintergrund

Traditionell dauert das Laden von Modellgewichten von lokalen Festplatten mehrere Minuten, und das Laden von Remote-Speichersystemen kann sogar noch länger dauern. Mit dem Wachstum der Modellgrößen wird die Zeit für die Initialisierung und Datenübertragung wahrscheinlich noch länger werden. Tensor R-Fork nutzt die hohe Bandbreite von InfiniBand, um diese Herausforderungen zu bewältigen.

Die Vorteile von Tensor R-Fork

- Signifikante Beschleunigung der Gewichtsladung: Durch die Nutzung von GPU-zu-GPU-Datenübertragung wird die Ladezeit von Modellen wie Deepseek-R1 von mehreren Minuten auf nur wenige Sekunden reduziert.

- Reduzierter Speicherbedarf: Die Methode eliminiert die Notwendigkeit, Modellgewichte lokal zu speichern, was den Speicherbedarf um etwa 600 GB verringert.

- Ununterbrochene Inferenzdienste: Die Übertragung der Gewichte erfolgt ohne Störung der laufenden Inferenzdienste, was eine nahtlose Benutzererfahrung gewährleistet.

Implementierung von Tensor R-Fork

Die Implementierung von Tensor R-Fork erfolgt über zwei Backend-Optionen: NCCL und TransferEngine. Beide haben ihre eigenen Vor- und Nachteile.

NCCL-Backend

Bei der Verwendung von NCCL als Backend wird der Prozess in zwei Phasen unterteilt: Zuerst werden Kommunikationsgruppen zwischen den Quell- und Zielinstanzen eingerichtet, gefolgt von der Übertragung der Gewichtstensoren. Während dieser Phase kann es jedoch zu Störungen der Inferenzdienste kommen, da die Quellinstanz aktiv an der Erstellung der Kommunikationsgruppen teilnehmen muss.

TransferEngine-Backend

Um die Störungen zu minimieren, wurde das TransferEngine-Backend entwickelt. TransferEngine nutzt GPU-Direct RDMA für eine effiziente Datenübertragung, ohne CUDA-Kerne auf der Quell-GPU zu aktivieren. Dies ermöglicht eine nicht störende Übertragung der Gewichte, was für produktive Umgebungen von entscheidender Bedeutung ist.

Leistung und industrielle Praxis

Die Leistung von Tensor R-Fork wurde an einer neuen SGLang-Instanz mit acht NVIDIA H20 GPUs evaluiert. Die Registrierung von Speicherbereichen kann mit anderen Initialisierungsphasen überlappt werden, um die Gesamtstartzeit weiter zu optimieren. In der industriellen Praxis wird die manuelle Konfiguration von Seed-Instanzen jedoch als unpraktisch erachtet. Daher wurde der Tensor R-Fork Planner entwickelt, um die Quellinstanz-Metadaten zu orchestrieren und die Effizienz zu steigern.

Zukunftsausblick

Die Einführung von Tensor R-Fork eröffnet neue Möglichkeiten für die Verwaltung von Tensoren in GPU-Clustern. Zukünftige Entwicklungen könnten es ermöglichen, zusätzliche Tensoren über das R-Fork-Mechanismus zu verwalten, wodurch GPU-Cluster nicht nur als Rechenzentren, sondern auch als Speicherzentren fungieren können.

Fazit

Tensor R-Fork stellt einen bedeutenden Fortschritt in der Optimierung der Modellgewichtsladung dar. Mit seinen innovativen Ansätzen zur Nutzung von GPU-zu-GPU-Datenübertragung und der Minimierung von Störungen in Inferenzdiensten wird es für Unternehmen, die große Sprachmodelle einsetzen, zunehmend unverzichtbar.

Quellenliste:

- Quelle: FAST MODEL LOADING

- Tensor R-Fork Documentation

- Tensor R-Fork with NCCL backend

- Tensor R-Fork with TransferEngine backend

Hinterlasse einen Kommentar

An der Diskussion beteiligen?Hinterlasse uns deinen Kommentar!