FINETUNING SPARSE ENCODERS WITH SENTENCE TRANSFORMERS

FINETUNING SPARSE ENCODERS WITH SENTENCE TRANSFORMERS

Die neueste Aktualisierung von Sentence Transformers bietet Unterstützung für das Training von spärlichen Einbettungsmodellen. Diese Entwicklung ist besonders wichtig für Anwendungen, die eine effiziente und interpretierbare Repräsentation von Textdaten erfordern. In diesem Artikel werden wir die Grundlagen von spärlichen Einbettungsmodellen, ihre Vorteile, die Notwendigkeit des Finetunings und die verschiedenen Komponenten des Trainingsprozesses untersuchen.

Was sind spärliche Einbettungsmodelle?

Spärliche Einbettungsmodelle sind eine spezielle Art von Einbettungsmodellen, die hochdimensionale Vektoren erzeugen, in denen die meisten Werte Null sind. Im Gegensatz zu dichten Einbettungsmodellen, die typischerweise niedrigdimensionale Vektoren erzeugen, bieten spärliche Modelle eine höhere Interpretierbarkeit, da jede aktive Dimension einem bestimmten Token im Vokabular des Modells entspricht.

Vorteile von spärlichen Einbettungsmodellen

Spärliche Einbettungsmodelle bieten mehrere Vorteile, darunter:

- Hybridpotential: Sie können effektiv mit dichten Modellen kombiniert werden, insbesondere in Szenarien, in denen lexikalische Übereinstimmungen wichtig sind.

- Interpretierbarkeit: Die aktiven Dimensionen in spärlichen Einbettungen ermöglichen es, genau zu sehen, welche Tokens zu einem Match beitragen.

- Leistung: In vielen Retrieval-Aufgaben sind sie wettbewerbsfähig oder besser als dichte Modelle.

Notwendigkeit des Finetunings

Das Finetuning von spärlichen Einbettungsmodellen ist entscheidend, um sicherzustellen, dass das Modell die spezifischen Anforderungen der Anwendung erfüllt. Durch das Finetuning kann das Modell lernen, relevante Synonyme und verwandte Begriffe zu erkennen, die für die jeweilige Domäne wichtig sind.

Komponenten des Trainings

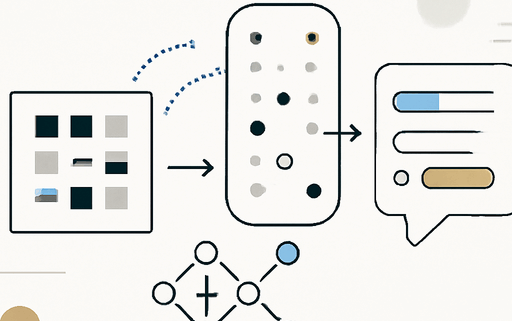

Der Trainingsprozess für spärliche Einbettungsmodelle umfasst mehrere Komponenten:

- Model: Das zu trainierende oder finetunende Modell, das ein vortrainiertes spärliches Encoder-Modell oder ein Basis-Modell sein kann.

- Dataset: Die Daten, die für das Training und die Evaluierung verwendet werden.

- Loss Function: Eine Funktion, die die Leistung des Modells quantifiziert und den Optimierungsprozess leitet.

- Training Arguments: Parameter, die die Trainingsleistung beeinflussen.

- Evaluator: Ein Werkzeug zur Bewertung des Modells während oder nach dem Training.

- Trainer: Kombiniert das Modell, den Datensatz, die Verlustfunktion und andere Komponenten für das Training.

Integration in Vektordatenbanken

Nach dem Training der spärlichen Einbettungsmodelle ist der nächste Schritt die effektive Implementierung in Produktionsumgebungen. Vektordatenbanken bieten die notwendige Infrastruktur zum Speichern, Indizieren und Abrufen von spärlichen Einbettungen in großem Maßstab.

Fazit

Das Finetuning von spärlichen Einbettungsmodellen mit Sentence Transformers eröffnet neue Möglichkeiten für die Verarbeitung und Analyse von Textdaten. Mit den richtigen Techniken und Tools können Entwickler leistungsstarke Modelle erstellen, die in einer Vielzahl von Anwendungen eingesetzt werden können.

Quellenliste:

- Quelle: Training and Finetuning Sparse Embedding Models with Sentence Transformers

- Sentence Transformers

- Pretrained Sparse Encoders

Hinterlasse einen Kommentar

An der Diskussion beteiligen?Hinterlasse uns deinen Kommentar!