Representation Autoencoders für Diffusion Transformers

Latent Diffusionsmodelle erhalten ein Upgrade durch die Einführung von Representation Autoencoders (RAEs), die die herkömmlichen Variational Autoencoders (VAEs) durch vortrainierte Encoder ersetzen. Diese neue Architektur verbessert die Qualität der Bildgenerierung in Diffusion Transformers erheblich.

Einführung in Representation Autoencoders

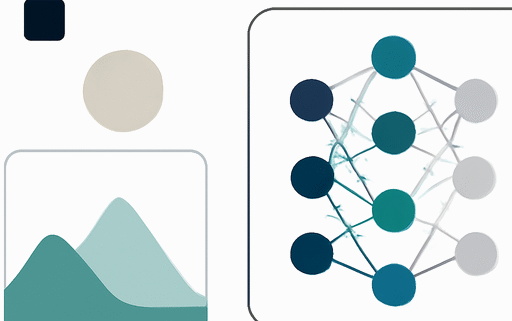

Die Verwendung von vortrainierten, gefrorenen Repräsentationseingängen zusammen mit leichtgewichtigen trainierten Decodern ermöglicht es, hochqualitative und semantisch reiche latente Räume für Diffusion Transformers bereitzustellen. Diese RAEs bieten sowohl qualitativ hochwertige Rekonstruktionen als auch semantisch reiche latente Räume, während sie eine skalierbare transformerbasierte Architektur ermöglichen.

Die Herausforderungen der herkömmlichen VAEs

Die meisten Diffusion Transformers basieren weiterhin auf dem ursprünglichen VAE-Encoder, der mehrere Einschränkungen mit sich bringt: veraltete Rückgrate, die die architektonische Einfachheit beeinträchtigen, latente Räume mit niedriger Dimension, die die Informationskapazität einschränken, und schwache Repräsentationen, die aus rein rekonstruktionsbasiertem Training resultieren. Diese Faktoren schränken letztlich die generative Qualität ein.

Die Vorteile von RAEs

Die RAEs kombinieren gefrorene, vortrainierte Encoder wie DINO, SigLIP und MAE mit trainierten Decodern. Dies führt zu einer signifikanten Verbesserung der Rekonstruktionsqualität und der Repräsentationsfähigkeit. Empirische Ergebnisse zeigen, dass RAEs eine schnellere Konvergenz ohne zusätzliche repräsentative Ausrichtungsverluste erreichen.

Rekonstruktion und Skalierung

Die Rekonstruktion von Bildern mit RAEs zeigt, dass die Annahme, vortrainierte Repräsentationseingänge seien ungeeignet für Rekonstruktionsaufgaben, nicht zutrifft. Mit einem richtig trainierten Decoder können gefrorene Encoder tatsächlich starke Encoder für den latenten Raum der Diffusion darstellen. RAEs bieten eine Rekonstruktionsqualität, die mit oder sogar besser als die von SD-VAEs vergleichbar ist.

Optimierung der Diffusion Transformers

Die Integration von RAEs in Diffusion Transformers bringt jedoch auch Herausforderungen mit sich. Standard-Diffusionsrezepte funktionieren nicht ohne weiteres mit RAEs, da die Trainingsdynamik und das Rauschverhalten angepasst werden müssen. Um die Leistung zu optimieren, müssen die Breite der Diffusion Transformers an die Dimension der RAE-Token angepasst werden.

Ergebnisse und Ausblick

Die Ergebnisse zeigen, dass die Verwendung von RAEs in Kombination mit einer breiten, flachen Transformer-Einheit, die wir als DiTDH bezeichnen, die Effizienz und Effektivität der Bildgenerierung erheblich steigert. Die RAEs ermöglichen es, starke visuelle Generierungsergebnisse zu erzielen, wobei auf ImageNet ein FID-Wert von 1.51 bei 256×256 (ohne Anleitung) und 1.13 bei 512×512 (mit Anleitung) erreicht wird.

Fazit

In diesem Artikel haben wir die Überzeugung in Frage gestellt, dass vortrainierte Repräsentationseingänge zu hochdimensional und zu semantisch für Rekonstruktionen oder Generierungen sind. Wir zeigen, dass ein gefrorener Repräsentationseingang, gepaart mit einem leichtgewichtigen trainierten Decoder, eine effektive Lösung darstellt. RAEs sind ein vielversprechender Kandidat für das Training von Diffusion Transformers in zukünftigen generativen Modellierungsforschungen.

Hinterlasse einen Kommentar

An der Diskussion beteiligen?Hinterlasse uns deinen Kommentar!