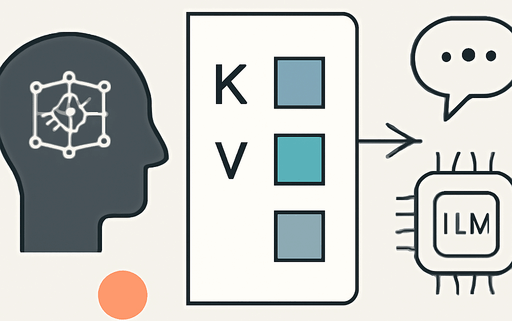

Verstehen und Implementieren des KV-Caches in LLMs

Key-Value (KV) Caches speichern Zwischenberechnungen der Aufmerksamkeit während der Inferenz von LLMs, um redundante Berechnungen zu vermeiden. In diesem Artikel werden wir die Funktionsweise von KV-Caches erläutern und eine Implementierung von Grund auf in Python bereitstellen.

Einführung in KV-Caches

KV-Caches sind eine der kritischsten Techniken für effiziente Inferenz in LLMs in der Produktion. Sie speichern Zwischenwerte, die während der Textgenerierung wiederverwendet werden können, was zu einer erheblichen Geschwindigkeitssteigerung führt. Die Herausforderung besteht jedoch darin, dass sie die Komplexität des Codes erhöhen und mehr Speicher benötigen.

Was ist ein KV-Cache?

Stellen Sie sich vor, ein LLM generiert Text. Wenn das LLM mit dem Prompt “Zeit” beginnt, generiert es nacheinander Tokens. Bei jedem Schritt wird der gesamte vorherige Kontext erneut verarbeitet, was ineffizient ist. Ein KV-Cache speichert die bereits berechneten Schlüssel- und Wertvektoren, um diese Wiederholungen zu vermeiden.

Textgenerierung ohne und mit KV-Cache

Ohne KV-Cache muss das Modell bei jedem neuen Token die vorherigen Tokens neu berechnen. Mit einem KV-Cache wird dieser Prozess optimiert, indem bereits berechnete Werte gespeichert und wiederverwendet werden. Dies reduziert die Berechnungen erheblich, insbesondere bei längeren Texten.

Implementierung eines KV-Caches von Grund auf

Die Implementierung eines KV-Caches kann auf verschiedene Arten erfolgen. Hier zeigen wir eine einfache, lesbare Implementierung. Wir verwenden zwei Python-Skripte, die ein LLM mit und ohne KV-Cache implementieren. Die Dateien sind:

Schritt 1: Registrieren der Cache-Puffer

Innerhalb des MultiHeadAttention-Konstruktors fügen wir zwei nicht persistente Puffer hinzu, die die Schlüssel und Werte speichern.

Schritt 2: Vorwärtsdurchlauf mit Cache-Flag

Wir erweitern die Vorwärtsmethode der MultiHeadAttention-Klasse, um ein use_cache-Argument zu akzeptieren. Wenn use_cache wahr ist, speichern wir die neuen Schlüssel und Werte im Cache.

Schritt 3: Cache zurücksetzen

Wir müssen den Cache zwischen zwei Textgenerierungsaufrufen zurücksetzen, um sicherzustellen, dass keine veralteten Werte verwendet werden.

Schritt 4: Verwendung des Caches in der Generierung

Schließlich zeigen wir, wie der KV-Cache in einer einfachen Textgenerierungsfunktion verwendet wird, um die Effizienz zu maximieren.

Leistungsvergleich

Wir haben die Implementierung getestet und festgestellt, dass die Verwendung eines KV-Caches eine Geschwindigkeitssteigerung von bis zu 5x bei der Textgenerierung ermöglicht. Dies zeigt, dass die Implementierung korrekt ist und die Effizienz erheblich verbessert.

Vor- und Nachteile von KV-Caches

- Vorteil: Erhöhte Rechenleistung durch Vermeidung redundanter Berechnungen.

- Nachteil: Erhöhter Speicherbedarf, insbesondere bei langen Sequenzen.

Optimierung der KV-Cache-Implementierung

Für den Einsatz in realen Szenarien ist es wichtig, die Implementierung zu optimieren. Dazu gehört die Vorabzuweisung von Speicher und die Implementierung eines gleitenden Fensters, um den Speicherverbrauch zu steuern.

Fazit

Obwohl Caching zusätzliche Komplexität und Speicherüberlegungen mit sich bringt, überwiegen die spürbaren Effizienzgewinne in der Regel die Nachteile, insbesondere in Produktionsumgebungen. Experimentieren Sie mit diesen Techniken und viel Spaß beim Programmieren!

Quellenliste:

- Quelle: Understanding and Coding the KV Cache in LLMs from Scratch

- Build a Large Language Model (From Scratch)

- Understanding and Coding Self-Attention in LLMs

Hinterlasse einen Kommentar

An der Diskussion beteiligen?Hinterlasse uns deinen Kommentar!