Wie Ein-Schicht-Transformer Regelsprachen erkennen: Eine theoretische Analyse der Trainingsdynamik und impliziten Bias

In der Welt des maschinellen Lernens sind Transformer-Modelle eine der bedeutendsten Entwicklungen der letzten Jahre. Sie haben die Art und Weise revolutioniert, wie wir natürliche Sprache verarbeiten und verstehen. In diesem Artikel werfen wir einen detaillierten Blick auf die Funktionsweise von Ein-Schicht-Transformern und deren Fähigkeit, Regelsprachen zu erkennen. Eine theoretische und empirische Analyse zeigt, wie diese Modelle selbst komplexe Aufgaben wie Paar- und Paritätsprüfungen erlernen können.

Einführung in die Thematik

Die Erkennung von Sprache ist eine fundamentale Aufgabe im Bereich der natürlichen Sprachverarbeitung (NLP) und wird häufig verwendet, um die Leistung großer Sprachmodelle zu benchmarken. Diese Aufgaben sind entscheidend, um die Arbeitsmechanismen von Transformern zu erklären. In dieser Arbeit konzentrieren wir uns auf zwei repräsentative Aufgaben der Regelsprachen-Erkennung, bekannt als „even pairs“ und „parity check“. Das Ziel dieser Aufgaben ist es, zu bestimmen, ob die Vorkommen bestimmter Teilfolgen in einer gegebenen Sequenz gerade sind.

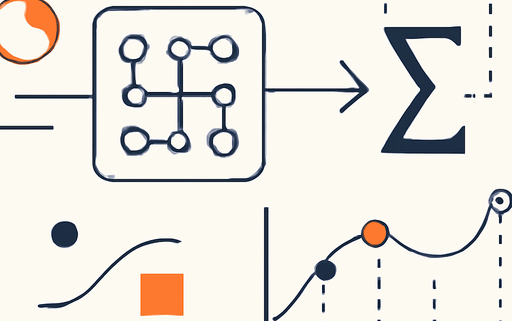

Die Struktur des Ein-Schicht-Transformers

Ein Ein-Schicht-Transformer besteht aus einer Aufmerksamkeits-Schicht, gefolgt von einer linearen Schicht. Unsere Analyse untersucht, wie ein solcher Transformer diese Aufgaben erlernt, indem wir seine Trainingsdynamik unter Gradientabstieg theoretisch analysieren. Während die Aufgabe „even pairs“ direkt von einem Ein-Schicht-Transformer gelöst werden kann, muss die „parity check“-Aufgabe durch die Integration von Chain-of-Thought (CoT) gelöst werden. Dies kann entweder in der Inferenzphase eines gut trainierten Transformers für die „even pairs“-Aufgabe oder im Training eines Ein-Schicht-Transformers geschehen.

Trainingsdynamik und Phasen

Unsere Analyse zeigt, dass das gemeinsame Training von Aufmerksamkeits- und linearen Schichten zwei verschiedene Phasen aufweist. In der ersten Phase wächst die Aufmerksamkeits-Schicht schnell und kartiert Datenfolgen in trennbare Vektoren. In der zweiten Phase stabilisiert sich die Aufmerksamkeits-Schicht, während die lineare Schicht logarithmisch wächst und sich in Richtung einer Max-Margin-Hyperplane bewegt, die die Ausgaben der Aufmerksamkeits-Schicht korrekt in positive und negative Proben trennt. Der Verlust verringert sich dabei mit einer Rate von $O(1/t)$.

Experimentelle Validierung

Unsere Experimente validieren die theoretischen Ergebnisse. Wir haben festgestellt, dass die Ein-Schicht-Transformer in der Lage sind, die „even pairs“-Aufgabe effizient zu lösen, während die „parity check“-Aufgabe eine tiefere Integration von CoT erfordert. Diese Erkenntnisse sind nicht nur für die theoretische Analyse von Bedeutung, sondern haben auch praktische Implikationen für die Entwicklung zukünftiger Transformer-Modelle.

Fazit

Die Untersuchung der Trainingsdynamik von Ein-Schicht-Transformern bietet wertvolle Einblicke in die Funktionsweise dieser Modelle. Die Fähigkeit, Regelsprachen zu erkennen, ist ein wichtiger Schritt in der Weiterentwicklung von NLP-Technologien. Die Integration von Chain-of-Thought in den Trainingsprozess könnte neue Wege eröffnen, um die Leistung von Transformern weiter zu verbessern.

Quellenliste:

- Quelle: How Transformers Learn Regular Language Recognition: A Theoretical Study on Training Dynamics and Implicit Bias

- Version 3 des Artikels

Hinterlasse einen Kommentar

An der Diskussion beteiligen?Hinterlasse uns deinen Kommentar!